多彩な分野で生成AIおよび大規模言語モデル(LLM)の利用が増加中である。一方で、入力プロンプト関連の脆弱性や、ハルシネーション(もっともらしい嘘)ないし不適切コンテンツの生成、情報漏洩、偏見惹起などの危険性が指摘されている――

LLMを利活用する企業はそれらの問題に、適切な対策を施す必要がある。昨今、生成AI系システム・サービス特化型のセキュリティ診断の重要性が叫ばれ――先進諸国では第三者プロによる診断の必要性について言及され始めているという。NRIセキュアは18日、「AIセキュリティ統制支援」のひとつとして、生成AIを利用するシステムやサービスに対するセキュリティ診断サービス「AI Red Team」の提供を開始した。

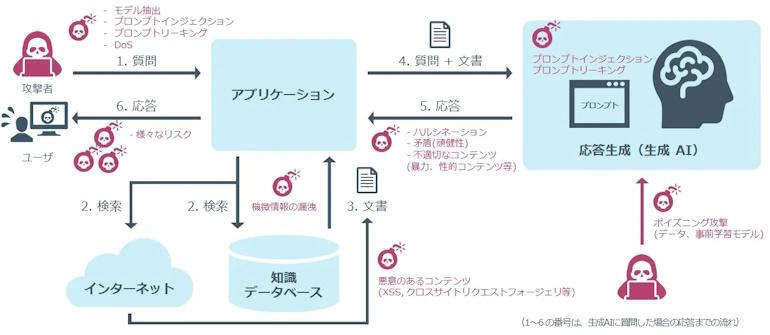

独自開発した自動テストと専門家による調査で効率的・網羅的・高品質な診断を実施、システムやサービス全体における実際のリスクを評価し対策コストを削減、といった特長を備えた。新サービスでは、同社の専門家が実システムに擬似攻撃を行うことで、LLM活用系サービスにおけるAI固有の脆弱性と、そのAIと連携する周辺機能を含めたシステム全体の問題点をセキュリティの観点から評価する。

サービス全体を俯瞰し、「リスクが顕在化した場合にシステムやエンドユーザに悪影響を与えるか」といった点でも判定を要するところで、LLM単体でのリスクを洗い出した後に、LLMを含むシステム全体のリスクを評定する。2段階に分けた診断を実施する。その結果、見つかった問題点とリスク低減策をまとめた報告書を提供する。

生成AI利用システム等のセキュリティ対策を継続的に支援していくため、AIアプリの定期モニタリングを実施する「AI Blue Team」を来年4月提供開始に向けて開発中である。現在そのPoC(概念検証)参加企業を募集している。同社は今後も、安全安心な情報システム環境と社会の実現に貢献していく考えだ。