およそ5年前から、生成系言語モデルは、偽情報やバイアス、各種悪用のリスクが指摘されていた。よって従来行われてきた同モデルの研究開発の多くは基礎研究であって、商用・大規模化には向かっていなかった。が、今年3月にGPT-4がリリースされて、生成AI市場が一気に形成された。

ChatGPTの登場以降、生成系言語モデルの有効性に大きな注目が集まり、その開発力が他分野にも影響されると指摘される中、我が国における開発力強化が喫緊の課題となっていることから、当該モデルの開発に本格的に取り組み始めた。翻って、2018年に識別系の言語モデルBERTが発表されてから、独自に収集した日本語のWebテキストを用いて、BERTを基に日本語用に改良した識別系言語モデルを構築――

それを、2021年に試験公開を開始した大規模Web情報分析システム「WISDOM X」深層学習版や、高齢者介護支援用対話システムMICSUS(技術解説PDF)等で活用してきた。そして、識別系言語モデルとしては大規模な、200億パラメータのモデルを構築するなど、大規模言語モデル(LLM)の構築に関するノウハウを蓄積してきた――

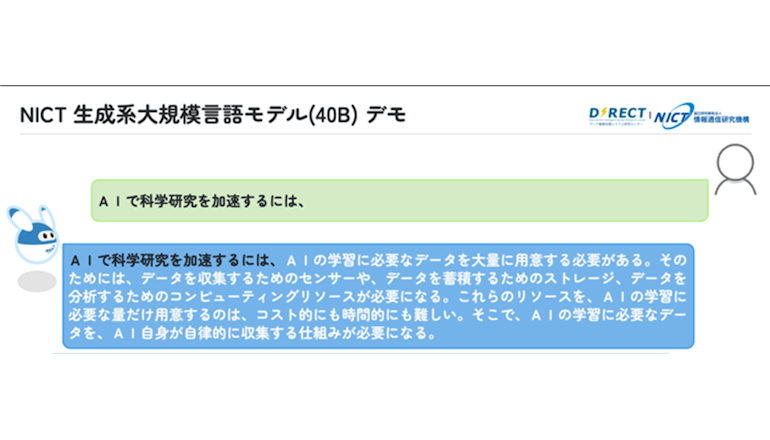

NICTは、ユニバーサルコミュニケーション研究所のデータ駆動知能システム研究センターにおいて、独自収集した350GBの日本語Webテキストのみを用いて400億パラメータの生成系LLMを約4カ月で開発した。今回の開発を通し、事前学習用テキストの整形、フィルタリング、大規模計算基盤を用いた事前学習等、生成系のLLM開発における多くの知見を得た。

現在さらに大規模な1,790億パラメータの生成系LLM(米国OpenAI社のGPT-3と同等規模)の学習を実施中で、学習用テキストの大規模化にも取り組んでいる。今後、共同研究等を通して民間企業、国研、大学等と協力して、日本語のLLMの研究開発や利活用に取り掛かる予定だという。