防犯や人材マッチング、金融取引等のシステムに組み込まれ、人がする重要な判断を支援している。AIは、多様なデータを用いて学習し、統計的に確率の高い答えを導出する。ゆえに昨今、教師データに含まれているバイアス(偏見)によって不公平な判定を下す危険性が指摘されている。

それを防ぐ各種提案、実装がされている。公平性の基準は、文化やビジネス慣習などで異なる場合があり、現在、AIシステムを構築するデザイナーがそれらを判断し、AIに反映させている――が、その設定が適切なものかを確認できない。このことが大きな課題になっていたという。

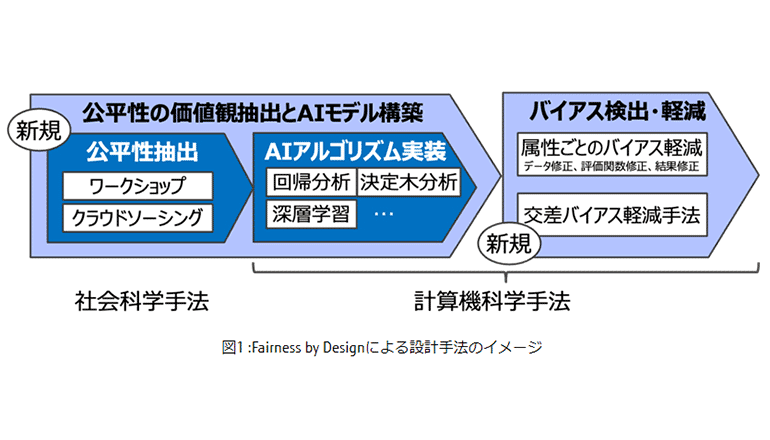

富士通研究所は、設計段階から公平性を考慮できるAIの開発手法Fairness by Designを開発した。同手法について、昨年12月~今年3月、欧州圏有数の銀行グループであるインテーザ・サンパオロ(ISP)と共同で実証実験を行い、地域ごとに異なる文化などの差異を考慮しながらローン審査AIアプリにおける公平性を改善できることを示し、その有効性を実証した。

社会科学で確立されている参加型デザイン手法を用いて、たとえばローン審査の判断基準となる収入、勤務先、取引履歴などの属性と、公平性に関わる年齢、性別、国籍等の属性の重みを数値化して、ビジネス要件と公平性をバランスさせたAIモデルが得られる。Fairness by Designには、偏見除去のために新開発した、交差バイアス(特定の属性の組み合わせにより、大きな差別が生じる現象)を軽減するアルゴリズムも組み込んだという。

実証実験では、日本・米国・英国に対応したローン審査AIを構築し、ISPが保有する23万件のデータにて審査を実施。応募者全体の約2%で、地域ごとの公平性により判断が異なることが明らかになった。さらに上記アルゴリズムを適用したところ、審査精度は地域ごとに大きく変わることなく、公平性が大幅に改善されたという。