人工知能(AI)技術は昨今、医療・ヘルスケア現場やスマート工場などでの活用に向かっている。末端のセンサーやウェアラブルデバイスからのデータをその場(エッジ)でリアルタイムに監視・分析する応用への期待が高まっている。

エッジAI実現の鍵は省電力にある。次世代AIのひとつ、リザバーコンピューティング(再帰的ニューラルネットワークの特殊モデル概念の発展形)は、ハードウェア実装時にディープラーニングよりも少ない電力かつ短い学習時間で動作する望みがある。それを実際に少ない電力で動作させるには、そのモデルサイズ(リザバー層構成ニューロン数)を小さく抑える必要があり、小くすれば予測精度が損なわれてしまう。

リザバーコンピューティングでエッジAIを実現するには、より小さいモデルサイズで一層高い予測精度を出す工夫が求められるという。東大生研の研究チームは、予測精度を損なわずに、モデルサイズを1/10に削減する手法を開発した。同手法を用いることにより、標準的な予測タスクで最大10分の1までモデルサイズ削減可能なことを示した。研究成果の一部は「ブレインモルフィックAIプロジェクト」の助成による。

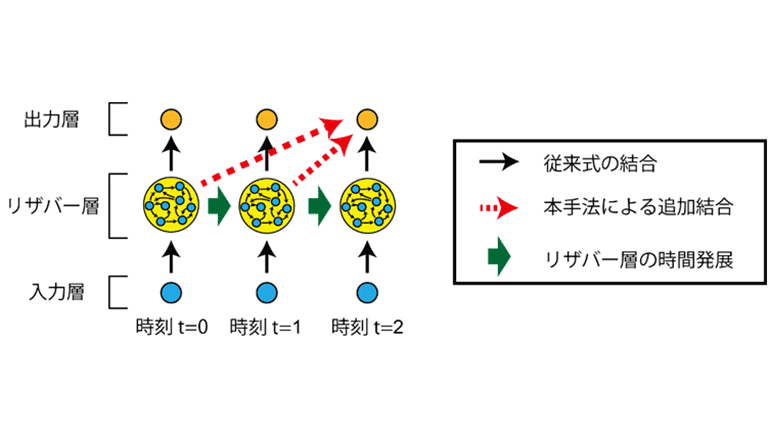

入力層、リザバー層、出力層で構成されているリザバーコンピューティングにおいて今回、リザバー層から出力層への結合構造を改良した。通常は時刻tのリザバー層から時刻tの出力層への結合のみを考慮するところで、複数の異なる過去の時刻t'のリザバー層から、時刻tの出力層への結合を追加した。これにより、リザバー層のモデルサイズは、追加した結合の数に応じて削減することが可能になるという。

ハードウェア実装の低消費電力化に繋がり、今後の人工知能の重要な応用であるエッジAIを可能にする。モデルサイズの削減手法は、東京大学とNECから特許出願(特願2019-206438)されていて、英サイエンティフィックリポーツ電子版で公開された。