この技術は、革新的な次世代人工知能基盤技術における研究開発成果の実用化加速のために2017年4月に設立した、理研AIP-東芝連携センターにおける成果。

ニューラルネットワークは、人間の脳の生物学的な仕組みを模したAIの計算モデルあり、近年ではこのネットワークを多層構造化したDNNを用いることで、より複雑で大規模な認識処理を行うことが可能になりつつある。

深層学習によって得られるDNNは人手による処理を必要とする従来の方法よりも高精度であると言われており、音声認識、機械翻訳をはじめ、自動運転向け画像認識まで様々な用途への適用が検討されている。

しかし、高い性能を実現するDNNは、大規模で複雑化する傾向があり、演算能力やメモリ量が限られたエッジデバイス上で動作させることが困難だった。このような大規模なDNNをコンパクトにする技術が複数の研究機関から提案されているが、特別な処理や追加学習が必要となるなど、手間がかかることが課題となっていた。

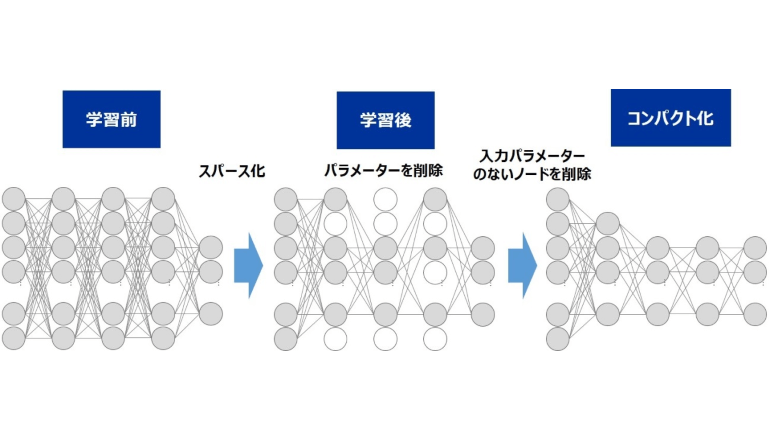

東芝は、深層学習を行う際に、DNNの一部のパラメーターが自動的にゼロ近傍に収束する「スパース化現象」を発見し、理研と共同でその発生原理を解明した。学習後にゼロとなったパラメーターは認識結果に影響しないことから、学習後にそれらのパラメーターを削除することでDNNのコンパクト化を実現した。

公開データセットを用いた実験では、この技術が、従来技術よりも認識精度の低下を抑えつつ、約80%のパラメーターを削減できることを確認。さらに、パラメーター削減率を調整し、DNNのサイズを柔軟に変更できる方法を開発した。

東芝と理研は今後、自動運転向け画像認識システムなど様々な組み込み機器やエッジデバイスにおける高度なDNNの活用にむけて研究開発を進め、本技術の2、3年後の実用化を目指す。