東大、究極の大規模光量子コンピュータ実現法を発明

東京大学 工学系研究科の古澤 明教授と武田 俊太郎助教らの研究グループが発明。

量子コンピュータは、スーパーコンピュータでも膨大な時間がかかる計算を一瞬で解くとされる新しい動作原理のコンピュータ。世界中で原子やイオン、超伝導素子など様々なシステムで汎用量子コンピュータの開発が進められている。

しかし、その大規模化は難しく、現在でも数十量子ビットの計算が限界。光を用いた量子コンピュータの場合も、その大規模化は長年の課題だったという。近年、1本の光路上で一列に連なった光パルス群を用いることで、量子もつれ状態にある100万個の光パルスの発生が実現され、それを用いれば大規模な計算処理が可能であることが分かった。一方で、この計算手法にも非効率的で計算精度が制限されるという課題があり、実現には至っていなかった。

研究グループでは、光路上で一列に連なった光パルスを用いる手法を生かしながら、大規模な計算でも最小規模の回路構成で効率よく実行できる究極の光量子コンピュータ方式を発明した。他のシステムで数十量子ビットが限界だった量子コンピュータも、この方式では原理的に100万個以上の量子ビットを処理できるような大規模化が見込めるという。

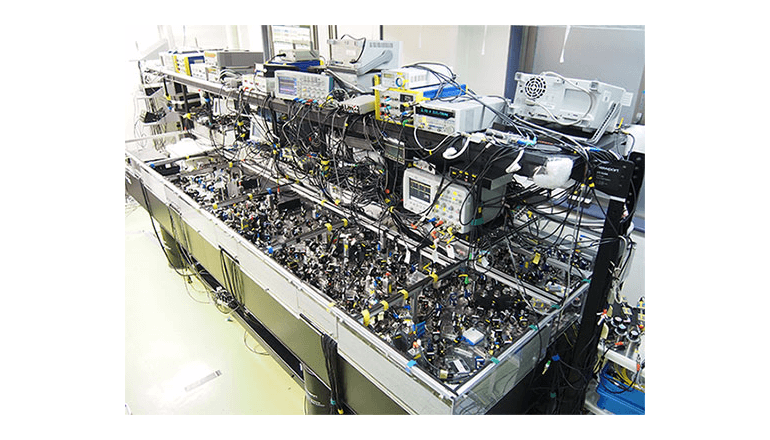

研究グループによると、ループ構造を持つ光回路を用いて、計算の基本単位となる「量子テレポーテーション」回路1個を無制限に繰り返し用いて大規模量子計算を行う方式を採用しているという。この方法では、光回路規模が極限まで小さくなる上、計算も効率よく実行できるため、量子もつれ状態を用いた計算手法の欠点がない。

また、同手法は光量子コンピュータの大規模化を促すと同時に、それに必要なリソースやコストを大幅に減少させ、光量子コンピュータ開発にイノベーションをもたらすと期待されると説明する。

今後は、光量子コンピュータにおける計算精度や各種アルゴリズムの実装方法について解析を進めながら、大規模量子コンピュータ開発に取り組んでいく方針だ。