表情とジェスチャーに応えるAIを開発

たとえば太古に猿を見た人が、ア、アと指さしてそれを仲間に知らせているうちに成立したのが指示表出のことばである。

一方、夕映えを見たり、花を見たりして心を動かされたときに出た声がやがて自己表出のことばになったという。吉本氏の理論によれば、自己表出性が高いものは感動詞であり、助詞、助動詞、副詞、形容詞、動詞、代名詞、名詞の順で、指示表出性に傾いてゆく。

日本人は助詞を多用するまれな民族――助詞こそ日本人を日本人たらしめていると筆者は思っている――であるため、自己主張が苦手というのは間違った概念かも知れない。

能書きはさておき、人工知能(AI)がある著名作家の作品を機械学習して書いたという文章を目にしたとき、「なんじゃこりゃ」と小生は唸った。実験当事者はその作家の文体が垣間見えるとしていたが、それは読むに堪えない代物で、何よりも助詞の使い方がめちゃくちゃであった。上司や先輩社員が新入社員の報告書を読んで「てにをは」の不出来を難詰するどころではなく、日本語の文章だとさえ思えなかった。

英作文用にプログラミングされているAIに和文を学習させた、そもそもの仕組みに無理があったにしても――。

AIは指示表出が得意である。感情に似た表現をしてもそれは、y=2x+1のようなアルゴリズムが働いた結果に過ぎない。

アルゴリズムを重層的に働かせるディープラーニング(深層学習)が実用化されつつあるにしても、現状コミュニケーションAIは、人の問いかけや命令を解読し、蓄積しているデータベースから最適解を引っ張り出してきてそれを提示するだけだ。

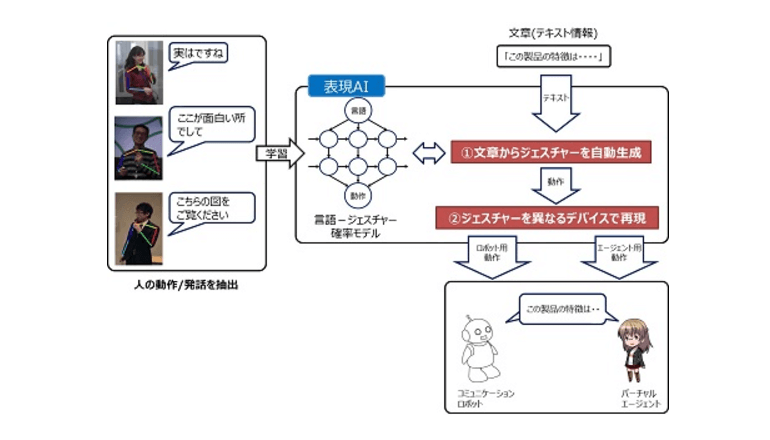

太古に我々の祖先が、ア、アと指さしていた意味も意図も理解できないだろう。と思っていたらきょう、DNPと国立電気通信大学の長井隆行研究室および中村友昭研究室は共同で、AIが、人間の言葉や表情、ジェスチャーに合わせて、自動的にその返答とジェスチャーを生成する「表現AI」の研究開始を発表。そのプロトタイプを'17年度中に開発し、実際の情報デバイスを利用した自動プレゼンテーションの実証実験を行う予定だとした。

労働生産性の向上に取り組むDNPは約3年前から「知能コミュニケーションプラットフォーム」の構築を進めている。一方、電通大は、人工知能先端研究センターが掲げる「人と共生して対応できる汎用性の高い人工知能システム」実現の一環として、AIが人間の成長過程と同様に、周囲の状況を観察・行動しながら異なる相手との相関関係を分析して自律的に成長していく「記号創発ロボティクス」(初出:人工知能学会誌 Vol. 27 No. 6)の研究を進めている。

――両者の発表には吉本理論を彷彿させられ、言語が生まれたときを想像させられた。