情報通信

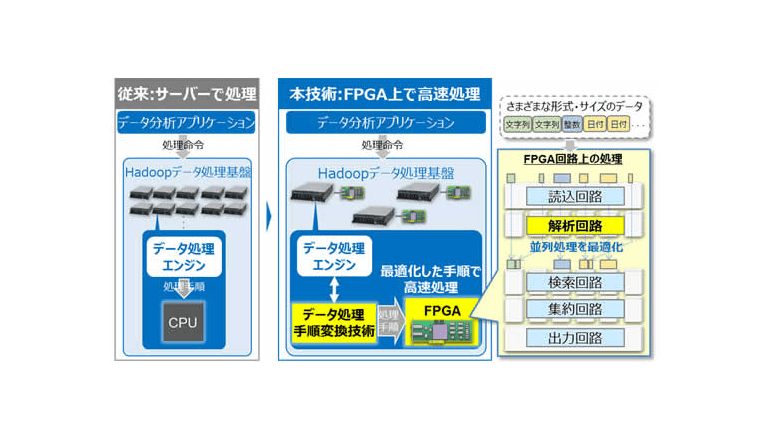

FPGA能力を最大化、Hadoopデータ分析を100倍速に

いわゆるビッグデータ、100万ギガバイト級のデータセットは、ソーシャルネットワークの台頭とともにその利用が現実となった。そして今、IoT時代を迎え、それはより広く産業界および社会インフラからも産み出され始めている。

膨大なデータを分析するしくみとして、Apacheソフトウェア財団の分散処理基盤「Hadoop」が注目されている。これはオープンソースのソフトウェアフレームワークであり、大規模データセットを数千ノード(≒プロセッサ)上に展開して検索や演算などをする。ファイルシステムは独自のもの(HDFS)だけでなく、AmazonやMicrosoft、OpenStackやFTP/HTTPS等経由でアクセスできるものもサポートしている。 一方、製造/物流/小売/金融/通信およびそれらのサービスを手掛ける企業では、ビッグデータを自社あるいは契約先のデータセンタで蓄積し処理する。当該データセンタでは、処理速度を上げる...